научное издание МГТУ им. Н.Э. Баумана

НАУКА и ОБРАЗОВАНИЕ

Издатель ФГБОУ ВПО "МГТУ им. Н.Э. Баумана". Эл № ФС 77 - 48211. ISSN 1994-0408

#9 сентябрь 2006

А.Г. Абрамов1, 2, В.Д. Горячев3, Д.К. Зайцев1, Е.М. Смирнов1

1Санкт-Петербургский государственный политехнический университет, 2Санкт-Петербургcкий филиал ФГУ ГНИИ ИТТ "Информика", 3Тверской государственный технический университет

Представляется учебный курс "Вычисления на многопроцессорных компьютерах", преподаваемый на кафедре гидроаэродинамики СПбГПУ. Особенностью данного курса является изучение не только базовых методов и технологий параллельного программирования и высокопроизводительных вычислений, но и вопросов их применения для решения сложных ресурсоемких задач вычислительной гидрогазодинамики и теплообмена. Дается характеристика академических программных комплексов SINF и CDF, предназначенных для решения трехмерных уравнений Навье-Стокса. Приводятся примеры выполненных на их основе расчетов.

1. Вопросы обучения технологиям параллельных вычислений

В настоящее время разработка и применение технологий параллельных вычислений в значительной мере определяет прогресс целого ряда отраслей науки и техники. В российских вузах образовательные программы в данной области находятся сегодня в стадии становления. Лишь несколько лет назад были изданы первые учебные пособия, в которых систематически излагаются вопросы архитектуры многопроцессорных вычислительных систем (МВС), технологий параллельного программирования и методов распараллеливания вычислительных алгоритмов. Ведущее место среди них занимает монография [1].

Вместе с тем, в известных авторам разработках по существу отсутствуют "мостики", которые позволяли бы учащимся в рамках единого образовательного курса перейти от освоения базовых методов и технологий параллельного программирования и высокопроизводительных вычислений к решению сложных ресурсоемких проблем, проистекающих из сегодняшних потребностей фундаментальных и прикладных отраслей науки и техники. Здесь достаточно упомянуть проблемы гидрогазодинамики и теплофизики применительно к областям произвольной геометрии и с определяющими эффектами нестационарности, задачи аэроакустики, комплексные проблемы совершенствования энергетических устройств и оборудования, многодисциплинарные задачи технологий производства материалов.

Представляемый в настоящей работе учебный курс "Вычисления на многопроцессорных компьютерах", преподаваемый на кафедре гидроаэродинамики Санкт-Петербургского государственного политехнического университета (СПбГПУ), призван частично восполнить указанный пробел. Программа учебного курса, рассчитанного на два семестра, состоит из шести разделов. Первый раздел посвящен основам операционных систем (ОС) семейства UNIX. Во втором разделе освещаются некоторые вопросы архитектуры высокопроизводительных компьютеров, а именно: принятые классификации МВС и особенности конкретных классов, способы оценки производительности параллельных компьютеров, типы коммуникационных сред МВС, их характеристики и другие вопросы. Современные технологии параллельного программирования рассматриваются в двух следующих разделах курса: дается обзор технологий параллельного программирования, подробно изучаются наиболее популярные на сегодняшний день технологии параллельного программирования OpenMP и MPI. Пятый раздел охватывает некоторые вопросы использования параллельных алгоритмов для типовых задач вычислительной математики. В нем, в частности, рассматривается широко применяющийся при численном решении задач механики сплошных сред метод декомпозиции расчетной области.

Последний, более специализированный раздел курса посвящен применению параллельных вычислений при решении ресурсоемких задач вычислительной гидрогазодинамики и теплообмена. Дается обзор развитых программных средств в данной области и подходы к организации в них параллельных вычислений. Приводятся основные характеристики двух развиваемых на кафедре гидроаэродинамики СПбГПУ программных средств: SINF [2, 3] и CDF [4], - предназначенных для решения трехмерных уравнений Навье-Стокса в областях сложной геометрии. Параллельные версии обеих программных пакетов (ПП), на основе которых проводятся расчеты на сетках размерностью несколько миллионов ячеек, базируются на использовании метода декомпозиции расчетной области и библиотеки MPI [5, 6]. Параллельная версия ПП CDF встроена в действующую открытую информационно-вычислительную среду cCFDd [4], развиваемую и поддерживаемую в Тверском государственном техническом университете (ТвГТУ) на основе использования кластерных систем с удаленным доступом и набором развитых пользовательских интерфейсов.

По пяти разделам курса организуются лабораторные занятия. Первый раздел посвящен освоению ОС UNIX. Второй и третий разделы - практическому изучению технологий параллельного программирования MPI и OpenMP на простых задачах. Четвертый - применению полученных навыков к распараллеливанию решателя модельных задач переноса, предоставляемого учащимся в исходном коде. Последний раздел посвящен накоплению практического опыта параллельных вычислений: расчеты ряда относительно сложных и важных для приложений задач гидрогазодинамики и теплообмена проводятся при запуске ПК SINF и CDF на кластерах в удаленном режиме.

2. Разработка программных средств для параллельных вычислений

2.1. Программный комплекс SINFНа кафедре гидроаэродинамики СПбГПУ на протяжении более 10 лет развивается программный комплекс (ПК) SINF (Supersonic to INcompressible Flows) для решения трехмерных уравнений Навье-Стокса. Подробное описание первой версии ПК содержится в работе [2], а история его развития и современные возможности - в работе [3]. К настоящему моменту ПК SINF позволяет проводить расчеты стационарных и нестационарных, до- и сверхзвуковых течений жидкости или газа, развивающихся, в общем случае, в областях сложной геометрии. Численный метод основан на использовании многоблочных структурированных совмещенных сеток, согласованных с границами области течения. Дискретизация пространственных операторов уравнений сохранения выполнена по методу конечных объемов со вторым порядком точности. Для получения нестационарных решений в ПК SINF реализована неявная трехслойная схема второго порядка по физическому времени. В случае течений несжимаемой жидкости и низкоскоростных течений газа на каждом временном слое итерации (продвижение по фиктивному времени) осуществляются или по методу искусственной сжимаемости, или по методу типа SIMPLEC, или по оригинальному гибридному методу. ПК SINF позволяет проводить расчеты турбулентных течений на основе широкого спектра высоко- и низкорейнольдсовых версий целого ряда одно- и двухпараметрических дифференциальных моделей турбулентности. Высокоточные расчеты могут проводиться на основе метода моделирования крупных вихрей и прямого численного моделирования.

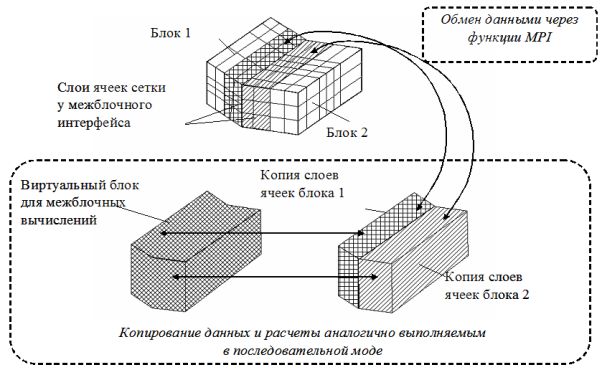

Распараллеливание ПК SINF базируется на применении метода декомпозиции расчетной области, стратегии SPMD (Single Proсess Multiple Data) и коммуникационной библиотеки MPI. Основная особенность распараллеливания касается обмена данными вдоль поверхностей, по которым происходит стыковка соседних блоков. В базовой "последовательной" версии ПК для целей обмена используется концепция вспомогательного виртуального блока. Такой виртуальный блок формируется из слоев приграничных ячеек каждого из стыкуемых физических блоков, с копированием всех данных, необходимых для расчетов потоков через поверхность (интерфейс) стыковки. Вычисления в виртуальном блоке проводятся по тому же алгоритму, что и внутри стыкуемых физических блоков. Принятая в ПК концепция виртуального блока обеспечивает сохранение консервативных свойств разностной схемы, облегчая тем самым решение многих проблем, возникающих при использовании сеток с обрывом сеточных линий на межблочном интерфейсе и/или при моделировании задач сопряженного тепломассообмена. В исходной версии ПК вычисления в виртуальных блоках производятся последовательно, интерфейс за интерфейсом, с использованием общей памяти. С целью достижения высокой эффективности распараллеливания и в стремлении избежать длительных вычислений в главном процессе, прилегающие к межблочным интерфейсам слои ячеек физических блоков копируются для использования в специальном процессе, который осуществляет межинтерфейсные обновления тем же способом, что и последовательной моде (см. рис. 1).

Рис 1. Схема обмена данными в параллельной версии ПК SINF.

К настоящему времени накоплен большой опыт использования параллельной версии кода при проведении расчетов на нескольких высокопроизводительных кластерах. Для всех рассмотренных задач (на расчетных сетках размерности от 1 до 20 миллионов ячеек) эффективность распараллеливания была более 0.8.

2.2. Программный пакет CDF в вычислительной среде cCFDd

Программный пакет CDF (Cartesian Domain Flow) предназначен для решения трехмерных уравнений Навье-Стокса на структурированных многоблочных сетках, покрывающих области прямоугольной геометрии [4]. На настоящий момент пакет обеспечивает возможность расчета течений несжимаемой жидкости и решения задач конвективного теплообмена, включая учет эффектов плавучести в приближении Буссинеска. Дискретизация пространственных операторов уравнений сохранения производится по методу конечных объемов со вторым порядком точности. При этом в отличие от программного комплекса SINF, используются разнесенные сетки, для которых значения различных компонент скорости и давления определяются в смещенных относительно друг друга узлах. При решении нестационарных задач для продвижения по физическому времени используется неявная трехслойная схема второго порядка точности. Внутренние итерации осуществляются либо по методу искусственной сжимаемости (при этом возможно использование как явной схемы первого порядка [6], таки и неявной схемы, основанной на линеаризации пространственного оператора с последующим приложением метода приближенной факторизации [7]), либо по методу SIMPLEC [8]. Параллельная версия программы CDF, также как ПК SINF, базируется на концепции многоблочности сеток с передачей необходимой вычислительной информации между стыкующимися блоками посредством MPI-функций [6].

ПП CDF является вычислительным ядром (решателем) разрабатываемой совместно сотрудниками СПбГПУ и ТвГТУ (в рамках многолетнего проекта SELIGER) вычислительной среды cCFDd (cluster Computational Fluid Dynamics domain) с удаленным доступом к кластерному вычислительному ресурсу в сети Интернет (см. рис. 2). Разработанная среда позволяет с помощью специализированных графических веб-интерфейсов, программно реализованных в виде Java-аплетов, генерировать модели многоблочных расчетных сеток, определять параметры рассчитываемой задачи, задавать граничные условия и параметры решателя. Для решения задач и быстрой адаптации используется механизм автоматического генерации интерфейсов (иерархических структур данных как деревьев и таблиц) на основе "мета" значений, описывающих параметры задачи (тип, диапазон значений, имя в предметной области, взаимосвязь параметров). Специализированная система управления расчетными проектами служит для хранения информации обо всех зарегистрированных в среде cCFDd задачах, а также для организации их "жизненного цикла".

При проведении нестационарных расчетов на удаленных кластерных системах приходится решать задачи доведения до пользователя результатов вычислений. Применительно к нестационарным задачам гидродинамики объемы передаваемых данных могут составлять десятки и сотни гигабайт. Для сокращения сетевого трафика в рамках проекта по развитию среды cCFDd ведется работа по созданию иллюстрирующих сцен на вычислительном сервере, с последующей пересылкой на компьютер пользователя графических файлов небольшого размера. Разрабатываемый для этих целей препроцессор основан на архитектуре клиент-сервер, с использованием "тонкого" клиента на базе протокола обмена Java RMI (Remote Method Invocation), что позволяет пользователю работать с системой непосредственно из веб-браузера, без установки специального программного обеспечения на клиентской стороне.

Рис. 2. Вычислительная среда cCFDd.

3. Примеры приложений разработанных программных средств

В данном разделе представляются результаты решения ряда задач гидродинамики и теплообмена, полученные методом прямого численного моделирования (Direct Numerical Simulation, DNS) с использованием параллельных версий ПК SINF и CDF на высокопроизводительных кластерных системах.

3.1. Турбулентная естественная конвекция в вертикальной замкнутой полости

Изучение режимов развитой турбулентной естественной конвекции в замкнутых высоких полостях с боковым подогревом представляет большой интерес с фундаментальных и прикладных позиций. Представляемые ниже расчеты проведены для условий экспериментального исследования [9]. Рассматривалась замкнутая полость с линейными размерами 28.68h:6.84h:h. Две вертикальные стенки, расположенные на расстоянии h друг от друга, поддерживались при различных постоянных температурах. Две другие вертикальные стенки полости полагались теплоизолированными, а на горизонтальных стенках задавались экспериментальные распределения температуры по данным [9]. В соответствии с условиями эксперимента число Релея принималось равным Ra=0.86×106, а число Прандтя - Pr=0.7.

Расчеты проводились на неравномерной сетке размерностью 1.5 млн. ячеек со сгущением ко всем стенкам полости. Для распараллеливания вычислений расчетная сетка была разбита на 8 блоков одинаковой размерности. Шаг по безразмерному времени принимался равным 0.1. Для статистической обработки результатов выбирался интервал в 150 временных единиц, которому предшествовал более короткий временной участок развития конвекции.

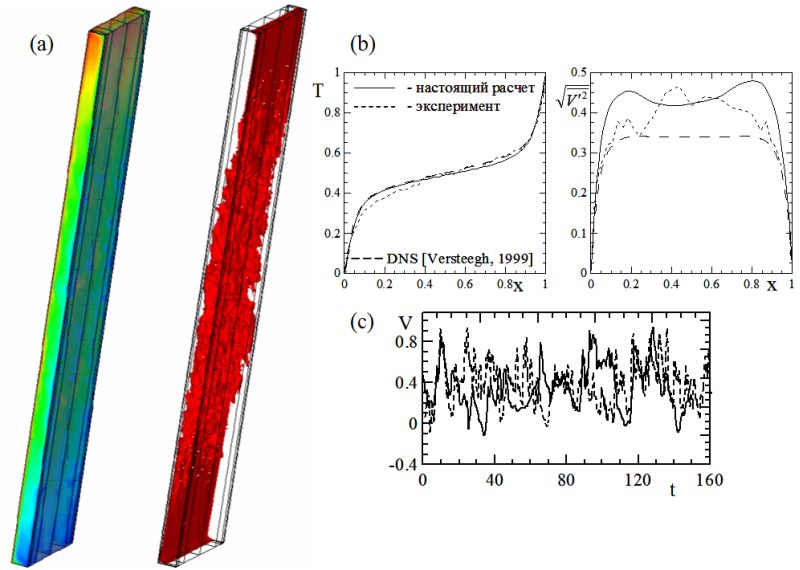

Рис. 3. Турбулентная естественная конвекция в вертикальной замкнутой полости.

Особенности структуры конвекции иллюстрирует рис. 3a, на котором показаны мгновенное поле температуры и изоповерхности температуры, соответствующие ее половинному перепаду. В полости развивается турбулентной течение сложной структуры. У вертикальных нагреваемой и охлаждаемой стенок формируются тонкие температурные пограничные слои. Вдали от стенок распределение температуры в вертикальном направлении соответствует устойчивой стратификации. Движение жидкости происходит в основном в области конвективной ячейки, ориентированной вдоль изотермических и горизонтальных стенок полости.

На рис. 3b производится сравнение рассчитанных профилей осредненной во времени температуры и среднеквадратичных пульсаций вертикальной компоненты вектора скорости в центральном горизонтальном сечении полости с данными эксперимента [9] и результатами DNS [10], выполненного на существенно более подробной расчетной сетке. Можно отметить хорошую степень согласования результатов настоящего расчета с данными указанных работ других авторов.

Типичный вид колебаний вертикальной скорости в точке мониторинга, помещенной в центре полости (рис. 3c), свидетельствует о наличии в рассматриваемом режиме конвекции интенсивных турбулентных пульсаций. Амплитуда пульсаций достигает 50% от масштабной скорости плавучести. Наблюдается хорошее согласование с экспериментально измеренными в работе [9] значениями по амплитудным и частотным характеристикам пульсаций.

3.2. Течение и теплообмен в модельной конфигурации пленочного охлаждения

Пленочное охлаждение является одним из способов эффективного охлаждения и защиты лопаток газотурбинных установок от воздействия высокой температуры рабочей среды. В таких системах подаваемый через ряд отверстий в теле лопатки относительно холодный воздух формирует защитную пленку между горячим газом и поверхностью лопатки. Постоянное стремление промышленности к снижению затрат и сроков проектирования новых типов газовых турбин делает весьма перспективным путь численного моделирования газодинамики и теплообмена в системах пленочного охлаждения.

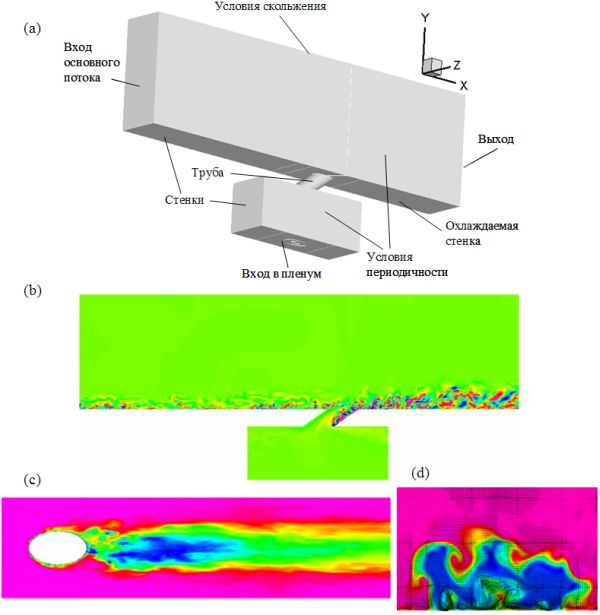

Представляемые расчеты модельной конфигурации пленочного охлаждения выполнены Смирновым П.Е. с использованием ПК SINF в рамках диссертационной работы [11]. Численно моделировалась задача охлаждения плоской пластины при подаче охладителя через одиночный ряд круглых отверстий, расположенных под углом к основному потоку (см. рис. 4a). Расчеты проводились для условий эксперимента [12] при числе Рейнольдса, построенном по диаметру D отверстия и скорости основного потока, равном Re=17400. Расчеты выполнены для отношения потока массы в охладителе и горячем газе, равного 0.5. Покрывающая расчетную область сетка имела размерность около 20 млн. ячеек.

На рис. 4а представлены расчетная область и граничные условия, принятые для расчетов модельной конфигурации пленочного охлаждения. Показанное на рис. 4b мгновенное распределение компонент скорости демонстрирует разрешение большого числа вихревых структур. Типичный вид мгновенного температурного поля на поверхности пластины (рис. 4c) свидетельствует о формировании вблизи отверстия большого числа хаотично распределенных по поверхности пластины малоразмерных зон с температурой охладителя. Происхождение этих зон поясняет рис. 4d, где мгновенные вектора скорости и распределение температуры показаны в плоскости x/D=1.5 (координата x отсчитывается от центра отверстия вниз по потоку, общий размер расчетной области в направлении x равен 20D). Анализируя явления в пристенной области можно заключить, что перенос частиц охладителя к пластине осуществляется посредством довольно мелких вихрей, образующихся вблизи стенки в результате взаимодействия струи с основным потоком. Одновременно с этим, вдали от стенки прослеживается наличие парных вихрей и других крупномасштабных вихревых структур, определяющих температурное поле в поперечном к основному потоку направлении. Таким образом, перенос тепла в поперечном и нормальном направлениях осуществляется вихревыми структурами существенно разного масштаба.

Рис. 4. Течение и теплообмен в модельной конфигурации пленочного охлаждения.

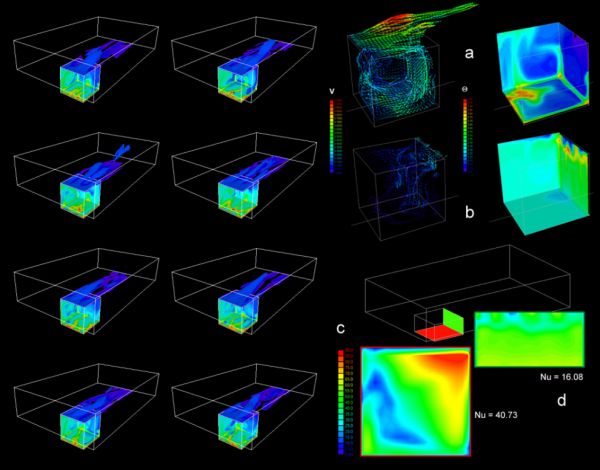

3.3. Смешанная конвекция внутри и над периодическим рядом вентилируемых каверн

В среде cCFDd было выполнено численное моделирование смешанной конвекции воздуха, развивающейся внутри и над рядом вентилируемых каверн, подогреваемых снизу или сбоку (ненагретые стенки каверн полагались адиабатическими). Рассматривалось течение с однородным распределением скорости потока над передним краем периодически расположенных прямоугольных каверн. Данная конфигурация служит полезной моделью для анализа ряда специальных задач, возникающих при проектировании промышленных сооружений.

Расчеты проводились для числа Рейнольдса, построенного по скорости основного потока над кавернами, равного 104. Эффекты плавучести в поле силы тяжести исследовались в диапазоне чисел Релея 3.5×108...1.4×109. Многоблочные расчетные сетки содержали до 430000 ячеек.

Рис. 5. Пространственная структура течения внутри и над периодическим рядом вентилируемых каверн: (a) при подогреве снизу, (b) при подогреве подветренной стенки. Распределение числа Нуссельта: (c) при подогреве снизу (d) при подогреве наветренной стенки.

Установлено, что характеристики глобальной циркуляции воздуха в каверне и нестационарные процессы генерации когерентных вихревых структур зависят от отношения сторон и способа нагрева стенок каверны. Нестационарные вихревые структуры генерируются за счет неустойчивости сдвигового слоя у верхней границы каверны, а также за счет неустойчивой температурной стратификации в ней. При подогреве снизу образующиеся термики сносятся основным потоком вдоль углов каверны и накладываются на глобальную циркуляцию, ориентированную вдоль одной из диагональных плоскостей каверны (рис. 5a,b). Образование и развитие когерентных вихревых структур в кавернах зависит от ее геометрической конфигурации (куб, параллелепипед). Процесс проникновения вихревых структур в основной поток над каверной носит квазипериодический характер. Вихревая пелена периодически с достаточно высокой частотой меняет направление транспорта частиц воздушного потока к левому или к правому ребрам каверны.

При нагреве наветренной или подветренной стенок каверны циркуляция воздуха менее интенсивна, чем для случая подогрева снизу (см. рис. 5c,d). Это неблагоприятно влияет на теплоотдачу от стенок и в результате ее интенсивность падает в 2-3 раза по сравнению со случаем подогрева снизу. Анализ полученных результатов для каверн разной геометрии показал, что наибольшая интенсивность теплопереноса наблюдается для подогреваемой снизу каверны с отношением сторон H:W:L=0.5:1:1, где H - глубина каверны. В этом случае интегральное число Нуссельта оказывается близким к 40. Для вариантов с боковым подогревом оно не достигает даже половины указанного значения.

Работа выполнена при поддержке Российского фонда фундаментальных исследований (гранты №№ 05-07-90038 и 05-02-17189).

ЛИТЕРАТУРА

- Воеводин В.В., Воеводин В.В. Параллельные вычисления. Серия "Научное издание". - СПб.: БХВ-Петербург, 2002. - 608 с.

- Smirnov E.M. Numerical simulation of turbulent flow and energy loss in passages with strong curvature and rotation using a three-dimensional Navier-Stokes solver / Report on the "Research in Brussels'92" Dept. Fluid. Mech., Vrije Universitet, Brussel, 1993, 122p.

- Смирнов Е.М., Зайцев Д.К. Метод конечных объемов в приложении к задачам гидрогазодинамики и теплообмена в областях сложной геометрии // Научно-технические ведомости СПбГПУ. 2004. № 2(36). С. 70-81.

- Goryachev V., Balashov M., Rykov D., Smirnov E., Rykova O., Yakubov S. Net informational and computational system for CFD researchers / Proc. 1st International Conference "From Scientific Computing to Computational Engineering", 1st IC-SCCE, Athens, September, 8-10, 2004.

- Smirnov E.M., Abramov A.G., Ivanov N.G., Smirnov P.E., Yakubov S.A. DNS and RANS/LES-computations of complex geometry flows using a parallel multiblock finite-volume code / In.: Parallel CFD - Advanced Numerical Methods Software and Applications, Chetverushkin et al (Eds), Elsevier, 2004, pp. 219-226.

- Якубов С.А. Параллелизация вычислений при решении задач гидродинамики на декартовых и криволинейных многоблочных сетках. Дисс. ... магистра. - СПб.: СПбГПУ, 2002. - 63 с.

- Рыкова О.С. Численное моделирование автоколебательных режимов трехмерной свободной конвекции в емкостях, подогреваемых снизу. Дисс. ... магистра. - СПб.: СПбГПУ, 2002. - 62 с.

- Цветков Б.Н. Численное решение задач динамики вязкой жидкости с использованием декартовых многоблочных сеток. Дисс. ... магистра. - СПб.: СПбГПУ, 2006. - 42 с.

- Betts P.L., Bokhari I.H. Experiments on turbulent natural convection in an enclosed tall cavity // Int. Journal of Heat and Fluid Flow, 2000, V.21, P. 675-683.

- Versteegh T.A.M., Nieuwstadt F.T.M. A direct numerical simulation of natural convection between two infinite vertical differentially heated walls scaling laws and wall functions // Int. Journal of Heat and Mass Transfer, 1999, V.42, P. 3673-3693.

- Смирнов П.Е. Численное моделирование трехмерного течения и теплообмена в условиях, типичных для организации пленочного охлаждения. Дисс. ... канд. физ.-мат. наук. - СПб.: СПбГПУ, 2005. - 135 с.

- Sinha A.K., Bogard D.G., Crawford M.E. Film cooling effectiveness downstream of a single row of holes with variable density ratio // ASME J. Turbomachinery, 1991. Vol. 113, P. 442-449.

Публикации с ключевыми словами: параллельные вычисления

Публикации со словами: параллельные вычисления

Смотри также:

Тематические рубрики:

| Авторы |

| Пресс-релизы |

| Библиотека |

| Конференции |

| Выставки |

| О проекте |

| Телефон: +7 (915) 336-07-65 (строго: среда; пятница c 11-00 до 17-00) |

|

||||

| © 2003-2024 «Наука и образование» Перепечатка материалов журнала без согласования с редакцией запрещена Тел.: +7 (915) 336-07-65 (строго: среда; пятница c 11-00 до 17-00) | |||||